AI

Verdens raskeste flashminne er utviklet – skriver data på 400 pikosekunder

Et teknologigjennombrudd fra Kina kan forandre fremtidens lagringsløsninger – og gjøre AI langt raskere og mer energieffektivt.

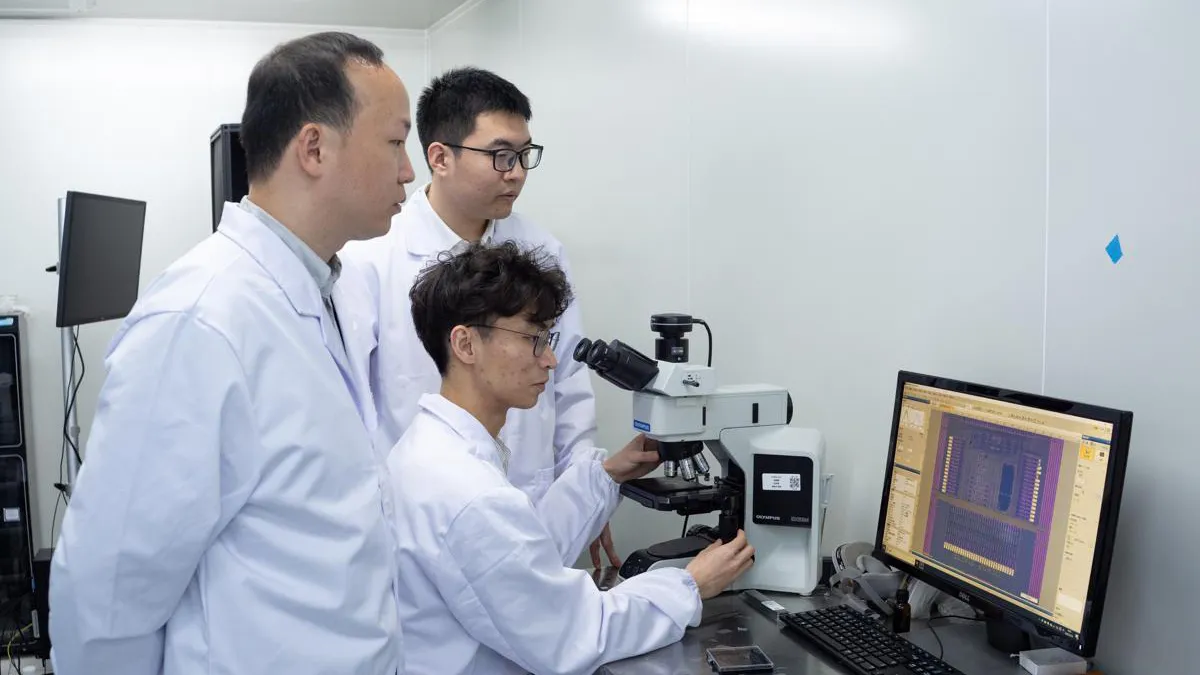

Forskere ved Fudan-universitetet i Shanghai har utviklet en ny type flashminne som kan skrive data på bare 400 pikosekunder – altså en tusendels nanosekund eller en trilliondel av et sekund. Det setter en ny verdensrekord og åpner døren for mye raskere og mer effektiv databehandling.

Les også: Undersøkelse avslører: Disse bilmerkene har de svakeste batteriene

Hva betyr dette i praksis?

Tradisjonelle minnetyper som SRAM og DRAM er raske, men mister all data når strømmen kuttes. Flashminne – som vi kjenner fra SSD-er og USB-pinner – er tregere, men holder på data uten strøm. Den nye teknologien kombinerer det beste fra begge verdener: Den er lynrask og mister ikke data når enheten slås av.

Slutt på AI-flaskehalser?

En av de største utfordringene i dagens kunstig intelligens (AI)-systemer er treg datalagring, som fører til ventetid, høyere strømforbruk og varmeutvikling. Den nye brikken, kalt PoX (Phase-change Oxide), kan gjøre det mulig å kjøre AI direkte på enheten – for eksempel mobilen – uten forsinkelser.

"Ved å bruke AI-algoritmer til å optimalisere testbetingelsene, har vi gjort store fremskritt og lagt grunnlaget for praktisk bruk," sier professor Zhou Peng til nyhetsbyrået Xinhua.

Slik fungerer teknologien

I stedet for vanlig silisium har forskerne brukt såkalt grafén – et ekstremt raskt ledende materiale i to dimensjoner. De har også justert strukturen i minnebrikken for å tillate en nærmest ubegrenset strøm av elektrisk ladning inn i lagringsområdet.

Resultatet? En dramatisk raskere og mer energieffektiv måte å lagre data på.

Klar for bruk i mobiler og PC-er

Teamet bak PoX-teknologien sier de allerede har laget en fungerende brikke i liten skala, og er nå i dialog med produsenter for å integrere den i fremtidige mobiltelefoner og datamaskiner.

"Neste steg er å integrere dette i vanlige enheter. Det vil eliminere problemer som treghet og overoppheting ved lokal bruk av AI-modeller," sier forsker Liu Chunsen ved Fudan-universitetet.